Markedsføringsbranchen har altid været dygtige till at pakke gammel fisk ind i nyt, skinnende papir. Nogle gange lidt for dygtige. Giv en støvet, gammel strategi, eller en metode der har fået meget kritik, et smart nyt navn, og vupti, pludselig er det en original og “banebrydende gamechanger”. Og nogle gange virker det, desværre.

En af de nyeste skud på stammen er: ”Programmatic SEO” (eller bare PSEO).

Men faktum er at der absolut intet grundlæggende nyt er ved det!

Hvad er Programmatic SEO?

Programmatic SEO er en metode til at generere og udgive store mængder søgemaskineoptimeret indhold automatisk. Typisk ved at kombinere strukturerede data med skabeloner og/eller AI-teknologi. Målet er at rangere på tusindvis (eller millioner) af long-tail søgeord ved at skabe landingssider i stor skala, uden at skulle skrive hver enkelt manuelt.

Det eneste, der virkelig er nyt her, er værktøjskassen. Ja, med AI er værktøjerne bestemt blevet mere funklende. Ja, de åbner op for nye tricks. Men gæt hvad? Der har altid været nye værktøjer og tricks! Det er ikke nyt. Den grundlæggende idé om at generere indhold - mere eller mindre automatisk, ud fra strukturerede data? Det er der bestemt intet nyt i!

Automatiseret indhold i historisk perspektiv

Både jeg og mange andre erfarne SEO-nørder har rodet med automatisk genereret indhold i årtier. Vi har prøvet det meste: fra simpel tekst-spinning, scraping og Markov-kæder til de tidlige dage med NLG (natural language generation, hvis du ikke er så vild med forkortelser).

For mit vedkommende startede det nok med simple tekst-spinners. Her tog vi tekster og udskiftede automatisk udvalgte or ud fra templates. På den måde kunne vi lave meget store mængder tekster meget hurtigt. Det virkede rigtig godt i nogle år. Men i takt med at Google blev bedre og bedre til at genkende næste identiske tekster blevet effekten mindre og mindre. Og det var da heller ikke altid, at ”spinnede tekster” endte med at fremstå så godt.

Lidt senere begyndte jeg at leget med scraping. Ideen her var, at tage en liste med de keywords vi gerne ville ranke på, scrape relateret indhold på nettet – typisk med udgangspunkt i søgeresultater på hvert ord, og så ”scramble” det, så ”vores” tekster fremstod unikt nok til at kunne udgive. I kombination med udløbne (expired) domains var det faktisk en super effektiv strategi omkring år 2005-20010. Den teknik alene betalte det meste af mit første hus og 2 gode biler!

Men som med alle af den slags stratgier, døde det på et tidspunkt ud. Det virkede ikke rigtig mere i Google.

Efter det arbejdede jeg bl.a. med Markow Chains, der sjovt nok har mange lighedspunkter med det som vi i dag kender som AI (eller mere korrekt: Large Language Models – LLM’er som ChatGPT).

Markow Chains er en matematisk model, der bruges til at beskrive systemer, hvor næste tilstand kun afhænger af den nuværende tilstand og ikke af, hvordan man kom dertil. Det kaldes Markov-egenskaben.

Det kan f.eks. bruges til at generere tekst eller modellere sandsynligheder, hvor hvert ord eller bogstav afhænger af det/de foregående.

Forestil dig, at du har en Markov-model, der analyserer en stor mængde tekst og beregner, hvilke ord der sandsynligvis følger efter hinanden. F.eks.:

- “Katten” → sandsynligvis efterfølges af “sidder”

- “Sidder” → sandsynligvis efterfølges af “på”

- “På” → sandsynligvis efterfølges af “måtten”

Så kunne modellen generere en sætning som: "Katten sidder på måtten" – uden egentlig at “forstå” meningen.

Det er i princippet det samme som LLM’er som ChatGPT gør. Forskellen på dem, og så det vi gjorde for år tilbage er, at de ovenpå den matematiske rå model har tilføjet nogle ”intelligente” filtre og logik der er med til at sikre, at det ikke bare ender som grammatisk korrekt sort snak.

Hvorfor give gamle metoder nye navne?

”Programmatic SEO” er som sagt gammel kage i nye pakker. Det er i bund og grund automatisering og skalering af indhold – bygget på struktureret data.

Men hvorfor så give det et nyt navn – når nu der bare er tale om lidt bedre værktøjer til at gøre det vi altid har gjort?

Det er som sagt langt fra første gang jeg har oplevet det her. ”Programmatic SEO” er blot det sidste nye skud på stammen af marketing bullshit.

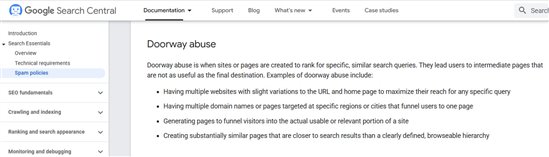

Jeg har tidligere oplevet det sammen med f.eks. ”Doorway Pages”, som var en meget udbredt teknik til at lave målrettede SEO-sider. Google begyndte så at slå lidt hårdere ned på den slags, og nævner dem den dag i dag stadig i deres Spam Policies guidelines.

Der var naturligvis mange virksomheder der blev opmærksom på det, og det blev derfor sværere for SEO-bureauer, at sælge Doorway Page løsninger.

Men så var der nogle (lidt for smarte) bureauer, der opfandt ”Zebra Pages”. Det lød jo skidesmart og utroligt innovativt. Så det var der nogle kunder der hoppede på.

Problemet var bare, at det helt grundlæggende var det samme som Doorway Pages, og Google er altså skideligeglade med hvad vi kalder det vi laver. De forholder sig alene til hvad det faktisk er.

Så i dette eksempel, som jeg også mener det i høj grad er tilfældet med ”Programmatic SEO”, er motivationen for at markedsføre de nye navne, som regel:

1) At man som leverandør/bureau ønsker at fremstå som mere nyskabende i markedet end man faktisk er

2) At forsøge at bilde kunderne ind, at det her slet ikke er det samme, som noget andet der enten kan opfattes negativt af Google, domstole eller som er blevet kritiseret offentligt af andre grunde

Der har gennem tiden været mange forskellige udmeldinger fra Google omkring automatiseret indhold. De er gået fra tage afstand fra al automatiseret indhold til i dag, at have en lidt blødere tilgang til det. Fokus er at fremme godt indhold, der lever op til deres principper om erfaring, ekspertise, autoritet og troværdighed (de såkaldte EEAT parametre).

Men da mange virksomheder, med rette, er blevet lidt nervøse for automatisk generering af større mængder indhold – bl.a. grundet Googles kritiske tilgang til det, så er det jo smart at kalde det man faktisk gør for noget helt andet. Lidt for smart, hvis du spørger mig.

Og nej, jeg synes ikke det er så innovativt, at det berettiger et helt nyt navn! Det er bullshit.

Da vi gik fra tekstspinners, over scraping til Markow Chains og NLG kaldte vi det heller ikke grundlæggende noget nyt hver gang. Uanset de værktøjer der blev brugt, handlede det om automatisering af indhold, baseret på struktureret data. Og det gør det stadig!

Og de udfordringer vi altid har haft med automatisering af indhold, er stadig de samme – at skabe indhold der kan skabe gode rankings i Google, som de ikke opfatter som spam, og som formår at overbevise læsere om, at handle med os.

Med hver ny generation af værktøjer til automatisering af holdhold har vi fået bedre muligheder for at skabe godt indhold. NLG var meget bedre end tekst-spinners. Og ja, nutidens AI-baserede værktøjer er bestemt endnu bedre.

Men det vi grundlæggende laver, er automatisering af indhold og udfordringerne er de samme!

Og ja, der er i høj grad stadig udfordringer – selv med de bedste AI værktøjer, i forhold til at lave indhold der virkelig fremstår originalt, bygger på reel ekspertise, er eftertænksomt, har autoritet og er rigtig troværdigt. Tekster der sælger.

Jeg siger ikke at AI ikke kan bruges. Jeg gør det selv dagligt. Man skal bare ikke tro, at det helt automatisk løser alle udfordringer.

Se, hvad der gemmer sig bag facaden!

Moralen i alt det her er, at du aldrig – som køber af markedsføringsydelser, blindt bør lade dig imponere af smarte ord og betegnelser for metoder, teknikker eller strategier, der kan lyde enormt innovative.

Se, hvad der gemmer sig bag facaden!

Hvad er det der faktisk tilbydes? Hvad laver leverandøren helt præcist for dig? Og i hvilket omfang kan det have negative konsekvenser for dig – enten i forhold til hvordan potentielle kunder opfatte det, hvordan Google opfatter det eller juridiske faldgrupper (f.eks. ophavsret, når vi nu snakker AI).

Hverken kunder, Google eller domstole forholder sig til det du kalder det du gør, men alene hvad det faktisk er. Og det bør du også!

Bliv gratis medlem

Bliv gratis medlem