Alt for mange der arbejder med SEO stoler blindt på deres SEO-tools til analyse og optimering. Mange af disse værktøjer er skam ganske fine. Jeg bruger selv mange af dem. Men desværre lider de alle af et fundamentalt problem, der kan have katastrofale konsekvenser for din synlighed i Google.

Det skal vi se lidt nærmere på i dette indlæg.

Der findes mange værktøjer

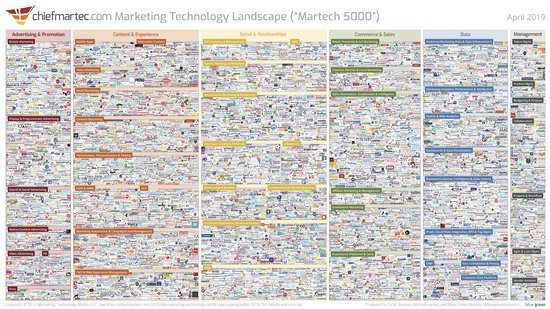

Der findes et utal af værktøjer i form af software og online tools der kan hjælpe med at analysere og optimere dine digitale kampagner. Ifølge den nyeste opgørelse fra ChiefMartech.com er der faktisk hele 7.040 i 2019. Mange af dem er mere eller mindre dedikeret til arbejdet med SEO.

Ref: https://chiefmartec.com/2019/04/marketing-technology-landscape-supergraphic-2019/

Hver især løser værktøjerne konkrete opgaver og kan hjælpe med analyser og optimering af dit arbejde med SEO. De kan være med til at identificere problemer, synliggøre dem og præsentere dem på en overskuelig måde.

Ingen har naturligvis brug for over 7.000 værktøjer. Og mange af dem overlapper da også hinanden. Personligt bruger jeg bl.a. Screaming Frog, SEO Monitor, Ahrefs, Majestic og SearchMetrics. Det synes jeg er gode SEO-tools som dagligt hjælper mig i mit arbejde.

Men på trods af at dette – efter min mening, er nogle af de bedste værktøjer på markedet lider de som nævnt i indledningen alle af den samme alvorlige fejl – eller måske rettere sagt, svaghed, som alle andre SEO-tools.

Du får svar på det du spørger om – ikke mere!

De fleste gode SEO-værktøjer er designet til at løse en konkret opgave, eller bruger en bestemt metode til at analysere data.

Screaming Frog, som et godt eksempel, er en såkaldt webcrawler. Den kan, lidt på samme måde som Googles crawlere, gennemtrævle et website, finde alle links, sider og andre objekter og på baggrund af det lave en række meget brugbare analyser.

Ahrefs bygger modsat Screaming Frog på en meget stor database, som de selv vedligeholder, over links på nettet og rankings i Google, som så kan bruges til at lave analyser af bl.a. hvem der linker til dig, dine konkurrenter, hvilke keywords du og de ranker på og hvor der er huller i markedet du kan udnytte.

Begge værktøjer er rigtig gode, til det de gør. Men fælles for begge disse – og alle andre SEO-værktøjer er, at de kun giver svar på det der bliver spurgt om, og det som de er designet til at kunne svare på. Ikke mere.

Det helt store problem er så, at svaret på dine udfordringer med at skabe større synlighed i Google – eller vende en nedadgående kurve, ikke nødvendigvis findes i disse – eller nogle andre, værktøjer.

I værste fald kan du have alvorlige problemer eller svagheder på dit website som begrænser, eller ligefrem undergraver din synlighed i Google og som dine værktøjer ikke fortæller dig om.

Nogle gange kan værktøjerne justeres, så de giver vigtige svar, du ellers ikke ville få. Men det kræver, at du ved hvad du vil have svar på. Du får (i bedste fald) kun svar på det du spørger om.

En tommestok måler, på trods af navnet, som udgangspunkt afstande i centimeter. Nogle af dem er så, så smart indrettet at tommemål står på bagsiden. Men det kræver at du ved du kan vende den om for at få svaret. Har du brug for at se afstanden i ”alen” eller andre mere eller mindre obskure måleenheder, så kan din tommestok slet ikke give dig svaret.

Et site der var ved at forsvinde (i Google)

For nyligt blev jeg kontaktet af en større dansk online virksomhed. De var mildt sagt lidt i panik. I løbet af de sidste måneder var deres synlighed i Google faldet til omkring det halve og måned for måned blev de mindre og mindre synlige.

Jeg kunne hurtigt bekræfte problemet og at omkring 25.000 sider blev fjernet i Googles indeks – hver eneste uge! Hvis ike der blev sat hurtigt ind med en løsning ville de i løbet af få måneder ikke have en eneste side tilbage i Google – og dermed miste al deres organiske trafik. Så det var en alvorlig sag.

De havde haft flere andre ”SEO-eksperter” til at se på problemet, men jeg mistænker at de i alt for høj grad har stolet på deres SEO-værktøjer. For de forslag til forbedringer de havde fundet frem til, hjalp ikke.

Det var sådan set ikke fordi, at de forbedringer de der var foreslået, var forkerte. Der var blandt andet nogle svagheder i den interne linkstruktur, lidt duplikeret indhold og nogle mangler i forhold til Schema-data. Men der var – for mig at se, helt tydeligt nogle langt mere alvorlige underliggende problemer, som undergravede alle andre forsøg på optimering.

Det svarer lidt til hvis din mekaniker foreslår at få repareret nogle rusthuller og skiftet olie på din bil, når det altoverskyggende problem er, at alle fire hjul er punkteret. Uanset hvor meget rust du fjerner, kommer lortet ikke ud at køre uden hjul!

Som at finde en nål i en høstak

At finde løsninger på den her slags problemer kan sammenlignes lidt med ikke bare at finde en nål i en høstak – men at finde et ukendt antal nåle i et ukendt antal høstakke.

En crawling med Screaming Frog af deres website viste ikke umiddelbart nogle tydelige tegn på problemer, der kunne forklare den stærkt faldende synlighed. Standardrapporteringen vise alene de samme skønhedspletter, som de andre SEO-folk også havde påpeget.

Screaming Frog crawler som udgangspunkt med en user agent der imiterer en almindelige desktop browser. Men det kan faktisk justeres. Og da Google, som du måske allerede ved, er gået over til at crawle med en mobil agent, prøvede jeg at crawle sitet med en sådan. Og det gav pote!

Det viste sig nemlig, at de havde en gammel mobil-version af deres website liggende på et subdomæne (m.domain.dk). Når man besøgte websitet med en mobiltelefon (eller en webcrawler der imiterer en mobil agent) blev man viderestillet til den mobile version.

I praksis betød det, at Google stille og rolig var i gang med at fjerne hele deres primære website fra indekset – for med deres mobil crawling kunne de jo slet ikke få adgang til det.

At opbygge et website med en separat mobilversion på et subdomæne – frem for et moderne responsivt design, er generelt set en rigtig dårlig løsning. Og i lige præcis den her situation – hvor Google få måneder forinden var overgået til mobil crawling, var den en af de afgørende årsager til af-indekseringen.

At opdage det krævede en justering af SEO-værktøjet. Spørgsmålet skulle ændres for at få det nødvendige svar. Dem der havde kigget på sitet tidligere, havde åbenbart ikke vidst det. Og ingen af de SEO-værktøjer jeg kender til ville automatisk have fortalt dem at de skulle det.

Det bliver meget værre …

Nu havde jeg fundet det som meget vel kunne være den primære årsag til den alvorligt faldende synlighed i Google for denne kunde. Men jeg stoppede ikke her. For min erfaring er, at der ofte gemmer sig endnu flere – og måske endnu mere alvorlige problemer, bagved dem man i første omgang ser.

At din bil har fire flade dæk er naturligvis et problem. Men at skifte dem hjælper ikke en skid, hvis motoren er brændt af.

Og jeg fik (desværre) ret. Det var ikke det eneste alvorlige og ”skjulte” problem de havde. Det viste sig nemlig, at der var et om muligt endnu større problem som SEO-værktøjerne – og de tidligere SEO-eksperter, heller ikke havde afsløret.

Problemet var at Googlebot – den useragent Google bruger når de crawler et website, helt (eller i hvert fald delvist) blev udelukket fra websitet. Det er naturligvis et meget seriøst problem. For hvis Google slet ikke kan få adgang til websitet, så vil de fjerne alle sider fra deres indeks i takt med at de forsøger at genbesøge siderne. Og det var lige præcis det vi oplevede.

Men hvordan fandt jeg så ud af det?

Også på dette punkt kan Screamning Frog justeres. Man kan vælge at crawle sit website med andre – end den almindelige Screaming Frog useragent. I det her tilfælde skiftede jeg til Googlebot og kunne så konstatere, at crawleren ikke kunne få adgang. Yderligere tests viste i øvrigt at det samme galt for BingBot og YandexBot – men ikke for DuckDuckBot, hvilket var en meget tydelig indikation på, at det her på en eller anden måde var en spærring som nogle specifikt havde lavet for disse tre crawlere og ikke et generelt crawling issue.

Så langt så godt. Ved at stille de rigtige spørgsmål – ved at justere vores SEO-tool, kunne jeg faktisk få de svar jeg søgte. Men som sagt kun fordi jeg vidste hvad jeg skulle ”spørge” om. Men hvad var årsagen til denne spærring så?

Det kan hverken Screaming Frog eller andre af de værktøjer jeg kender til automatisk svare på. Det kræver lidt mere manuelle undersøgelser og erfaring.

Det er ikke første gang jeg har oplevet samme type fejl. Og jeg gik derfor i gang med at undersøge de kilder til en sådan fejl, som jeg tidligere har oplevet.

Først tjekkede jeg med udviklerne om de – i opsætningen af deres webserver havde tilføjet denne spærring. Det havde de ikke. Næste skridt var derfor at se på hosting og CDN. Udviklerne mente selv, at problemet måtte ligge der – men mente i øvrigt ikke, at det var et problem.

Jeg fandt frem til at spærringen skyldes, at dette website benytter CloudFlare CDN til alle deres filer – herunder også HTML-siderne. CloudFlare har desværre, som standard, opsat nogle lidt uheldige regler for at begrænse uønsket trafik på deres netværk. Disse regler inkluderer et forsøg på at identificere falske besøg fra Google, Bing og Yandex.

Det er en lidt længere historie hvordan de lige gør det, men det er, mildt sagt, en forbandet dårlig løsning. For risikoen er, at der kommer falske positive med. Og det betyder så, at Google bliver udelukket fordi systemet tror det er et falsk besøg. Og det var min bedste vurdering at det kunne være sket i den her sag.

CloudFlare er ikke det eneste netværk der lave den slags uheldige spærringer. Jeg har gennem tiden oplevet flere andre meget store hostingudbydere gøre det samme.

Kreative udviklere skaber unikke problemer

Næsten hver eneste gang jeg laver en omhyggelig SEO-analyse af et website, finder jeg nye, kreative løsninger på struktur, kodning og funktioner, som jeg ikke tidligere har set. Webdesignere og udviklere er kreative mennesker. Og det er sådan set godt nok. Ofte er de nye løsninger ikke dårlige, men nogle gange kan de i alvorlig grad skade websitets mulighed for synlighed i Google.

SEO-tools vil som regel ikke være i stand til at spotte problemer der opstår som følge af helt nye måder at gøre ting på. For de kan jo kun undersøge det de kender. De giver kun svar på de spørgsmål vi stiller dem.

Jeg kan f.eks. huske en sag jeg havde for nogle år siden med et website der ikke blev korrekt indekseret. Jeg fandt hurtigt frem til, at de kreative udviklere havde implementeret hele navigationen på sitet med post-formularer og JavaScript event-handlers. Meget originalt, men en meget uheldig kombination, hvis man gerne vil crawles af Google.

Ingen af mine gode SEO-tools kunne spotte denne fejl. Det krævede manuel gennemgang af koden at finde ud af det.

Jeg oplever også jævnligt komplekse JavaScript-relaterede problemer, problemer med særlige former for duplicate content og svagheder og fejl i Schema-data eller AMP som mine SEO-tools heller ikke er i stand til at identificere.

For eksempel vælger mange website de forkerte Schema-objekter til deres data. Det er ikke nødvendigvis en fejl og rapporteres derfor ikke som sådan i f.eks. Screaming Frog. Men ved at vælge et andet objekt, kan sitet opnå fordele i Google de ellers ikke ville have.

I ovenstående case havde websitet f.eks. oprettet alle deres FAQ-sider med artikel-objektet. Det er ikke direkte en fejl, men de kunne få meget mere ud af at bruge det nye FAQPage-objekt.

At spotte den slags og at finde frem til de bedste løsninger kræver erfaring og manuel gennemgang. Ingen SEO-tools kan give dig alle de svar du har brug for!

Hvordan løses teknisk komplekse problemer?

En ting er at finde frem til hvad alvorlige problemer kan skyldes. Næste udfordringer, at få dem løst. Også her kommer standardiserede værktøjer til kort.

Hvis du arbejder med SEO og ønsker at få fjernet alle forhindringer for den bedst mulige synlighed skal du naturligvis kunne finde dem. Men det betyder ikke nødvendigvis, at du selv skal være i stand til at rette dem.

Der er mange ting jeg bestemt ikke er kompetent til selv at rette. Meget programmering og serveradministration kræver erfarne udviklere. Men du skal som SEO-ansvarlig være i stand til at tage dialogen med dine udviklere, forklare og dokumentere problemerne, så udviklerne kan rette dem, og efterfølgende teste at det nu virker som det skal.

Nogle gange kan du støde ind i udfordringer med udviklere der har fundet dokumentation fra Google, eller leverandører af hosting eller CDN, der fortæller at de problemer du har fundet slet ikke er et problem.

Men hvem har så ret?

Problemet er, at mange af disse informationer – både fra Google og andre er ”best case scenario”. Om alt går vel er kan deres forklaring godt være korrekte.

Hvis f.eks. CloudFlares identifikation af falske botbesøg er 100% korrekt opsat, så bør den i praksis ikke give problemer. Jeg ved så, af bitter erfaring, at det i praksis er så godt som umuligt at implementere en identifikation af bots der er 100% vandtæt. Enten vil der slippe falske besøg igennem – eller endnu værre, korrekt besøg vil blive identificeret som falske. Falske positive.

Som regel er mine anbefalinger som SEO-rådgiver baseret på det modsatte af bl.a. Googles – nemlig ”worst case scenario”. For når det går galt, er det dig der betaler prisen – ikke dem.

SEO er et håndværk

Uanset hvor mange lækre SEO-værktøjer vi har adgang til, er SEO et håndværk, der kræver indsigt, erfaring og teknisk forståelse. Hvis du alene stoler på dine tools, så er der alvorlig risiko for, at du overser alvorlige problemer, eller elementer der kunne optimeres bedre.

Bliv gratis medlem

Bliv gratis medlem